Se ti stai da poco approcciando al mondo della SEO o hai un sito web e desideri migliorarne la visibilità, dovresti conoscere il funzionamento dei motori di ricerca.

Come funzionano i motori di ricerca

I motori di ricerca si avvalgono di software detti spider, crawler o bot. I crawler analizzano ogni giorno infinite pagine web, le aggiungono al loro database e le organizzano in base a cluster semantici. Queste azioni serviranno a comporre la SERP per una determinata ricerca. Tutto questo avviene in tre processi distinti ma tra loro combinati:

- Scansione: il bot accede alle pagine del sito web e ne analizza contenuti che possono presentarsi sottoforma di testi, immagini, video, pdf, etc. Se queste pagine sono collegate ad altre pagine, attraverso dei link, il bot continua il processo di scansione anche su quelle pagine.

- Indicizzazione: dopo aver analizzato i contenuti, il crawler le memorizza nel suo indice.

- Posizionamento: attraverso determinati sistemi di ranking, i crawler decidono a quali pagine dare visibilità nella SERP seguendo un criterio di pertinenza con le domande degli utenti.

Ecco un ulteriore video approfondimento creato proprio da Google su come funzionano i motori di ricerca, spiegato in 5 minuti:

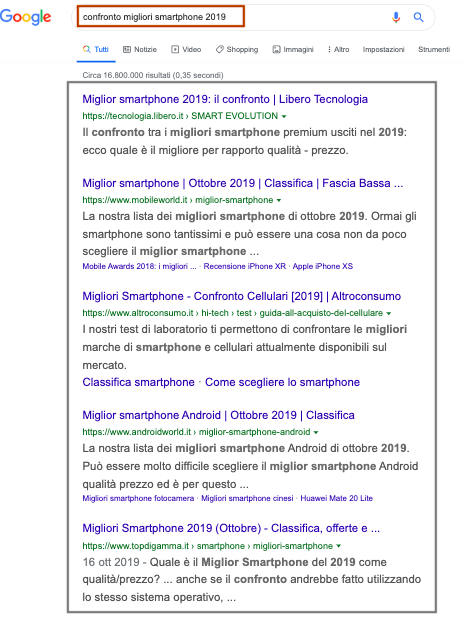

La SERP è la pagina dei risultati, restituita quando gli utenti digitano nel motore di ricerca una specifica query. Prendiamo come esempio quella di Google:

Principali motori di ricerca utilizzati in Italia: alcune statistiche

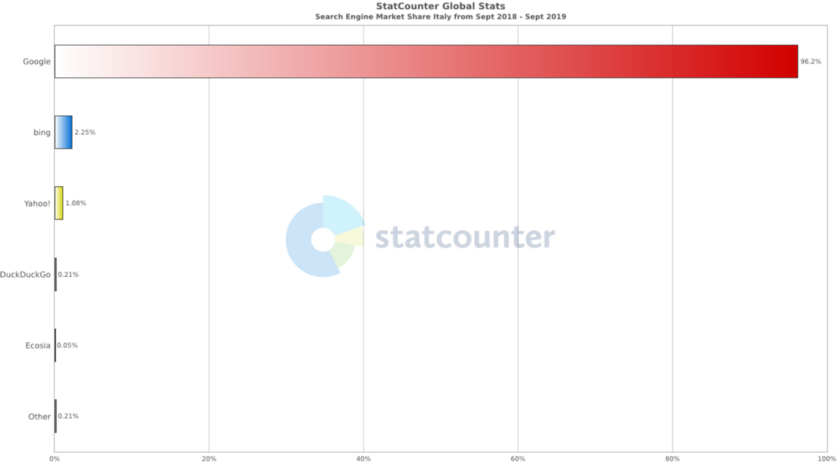

Secondo una statistica annuale di Statcounter, tra la lista dei motori di ricerca più utilizzati in Italia troviamo:

- Google che rappresenta la quota maggiore (96,2%),

- Bing con il 2,25%

- Yahoo con l’1,08%

Tra i tre, vince sicuramente Google il premio come miglior motore di ricerca, tuttavia non significa trascurare quella piccola percentuale di utenti che utilizzano anche Bing e Yahoo: l’obiettivo resta comunque quello di migliorare la visibilità del sito ed intercettare un pubblico di utenti più ampio, indipendentemente dal motore di ricerca utilizzato.

Scansione: analisi delle pagine web

Abbiamo parlato dell’importanza di far trovare le pagine web ai motori di ricerca.

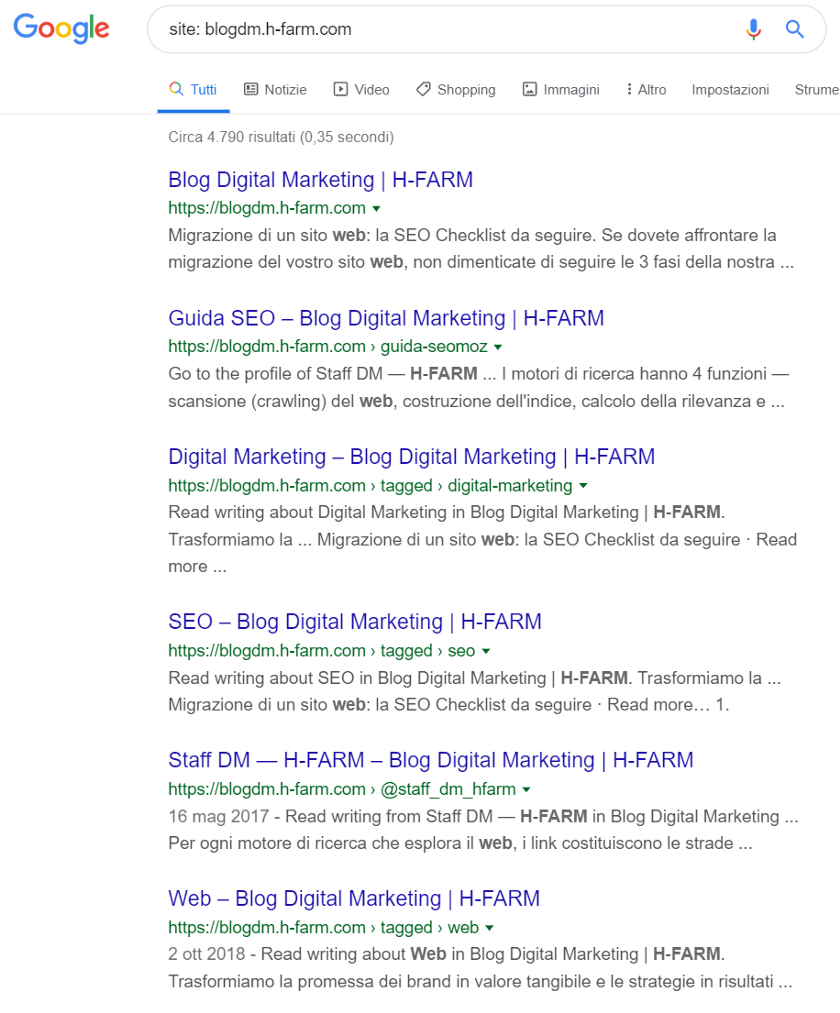

Prima di decidere come permettere ai crawler di accedere al tuo sito, ti invito a fare un piccolo test, inserendo nella barra di ricerca Google “site: miosito.com”, possiamo verificare, il numero di pagine indicizzate per quel dominio, e scoprire quali pagine sono raggiungibili dal motore di ricerca:

Bene, le pagine sono indicizzate, questo significa che i crawler le hanno scansionate. Ma come fa Google a scoprirle, prima di indicizzarle?

Vediamo quali sono i principali interventi che un sito deve implementare per essere certo di essere scansionato dai motori di ricerca:

- Robots.txt

- Collegamenti di pagine (link)

- Sitemap

Cosa sono i Robots.txt

Il file robots.txt, è un documento che permette di indicare ai crawler a quali pagine del sito accedere, attraverso regole specifiche. Può essere implementato anche in modo da impedire a tutti i crawler di scansionare il tuo sito, oppure può inibire la scansione di alcune aree del sito, a tutti gli User-Agent o ad uno specifico:

Robots che blocca la scansione a tutti gli User-Agent:

User-agent: *

Disallow: /

Robots che consente la scansione a tutti gli User-Agent:

User-agent: *

Disallow:

N.B: se metti un sito in disallow da file robots.txt potresti trovare comunque delle pagine indicizzate, ad esempio se ci sono link che puntano ad una delle tue pagine. Per essere certo di inibire la scansione è più utile il tag metarobots noindex.

Lo sai che dopo aver creato il file robots.txt, puoi consultarlo sul tuo sito? Digitando nella barra degli indirizzi del Browser: miosito.com/robots.txt.

Cosa si intende per collegamenti (link) tra pagine

I collegamenti tra pagine web (link) sono fondamentali per permettere a Google di visitare le pagine del sito. Quando i motori di ricerca trovano queste pagine le analizzano e le archiviano nel loro indice chiamato Caffeine. Creano così porzioni di pagine da scansionare e aggiornare frequentemente, con lo scopo di restituire agli utenti risultati più freschi e che soddisfino le loro ricerche.

Sitemap

La sitemap è il documento contenente l’insieme di url del tuo sito web, può essere in xml o html:

- la sitemap.xml viene generata per fornire ai crawler l’elenco di url presenti nel sito;

- la sitemap.html è molto utile per gli utenti che visitano il tuo sito, soprattutto se contiene molte pagine o pochi collegamenti tra link.

Quando il crawler non riesce ad accedere alle pagine del sito?

Esistono altri casi in cui i crawler non riescono ad accedere alle pagine del sito web, vediamo insieme quando succede e come è possibile risolverli:

Errori 404: come gestirli?

Abbiamo detto che i crawler seguono i collegamenti tra url. Può succedere che un link sia “rotto” e faccia atterrare l’utente su una pagina 404.

A quel punto si troverà costretto ad uscire dal sito o a cambiare pagina. Per risolvere gli errori 404 del tuo sito, ti consiglio di impostare dei redirect 301 che reindirizzano in maniera permanente la pagina inesistente (404) ad una attiva e navigabile, che il crawler potrà scansionare e aggiungere al suo indice. In alternativa, se non hai una pagina con un contenuto analogo a quella non più esistente, sarà più corretto impostare un codice di risposta 410, che indicherà al motore che la risorsa non è più disponibile e ne inibirà l’indicizzazione

Errori 5xx

Gli errori con status code 5xx sono errori del server. Si verificano quando l’utente o il motore di ricerca provano ad accedere ad una pagina del sito ma il server in cui si trova il sito web, non riesce a soddisfare questa richiesta

Tag Robots NoIndex

Potrebbe succedere che una pagina del tuo sito non venga più scansionata e visualizzata tra i risultati di ricerca. Controlla nell’<head> di quella pagina che non sia stato inserito involontariamente, il tag robots” NoIndex” e convertilo in “Index”

Sito in JavaScript

Il sito web sviluppato con linguaggio JavaScript sebbene performante in termini di User Experience e layout, rappresenta un limite in fase di scansione delle pagine in termini di tempo (crawl budget) e sviluppo tecnologico. Tuttavia, il motore di ricerca sta migliorando l’interpretazione di JavaScript.

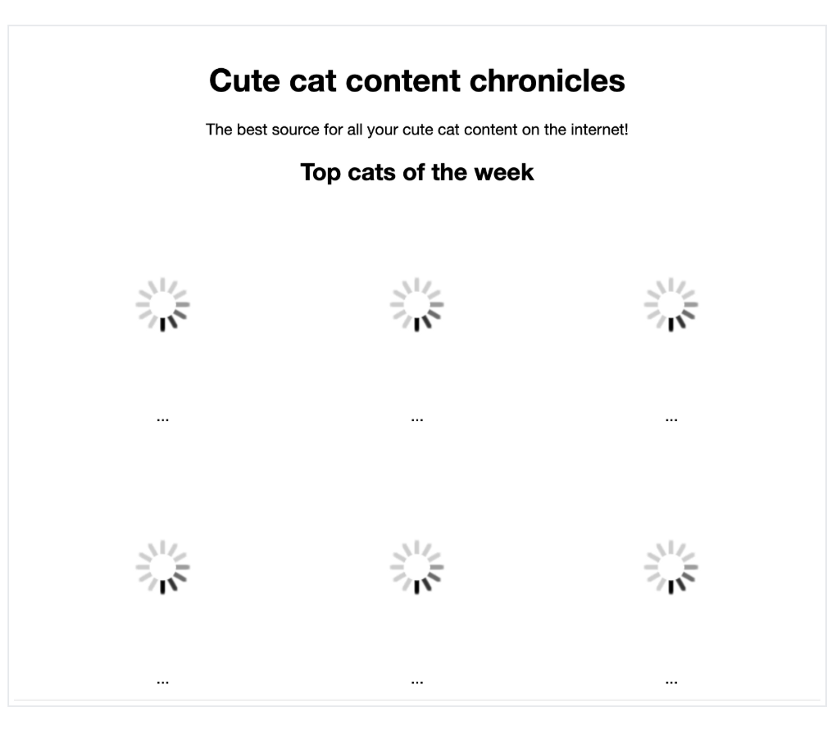

Vediamo un esempio di come viene visualizzato una pagina in JS dall’utente e dal crawler.

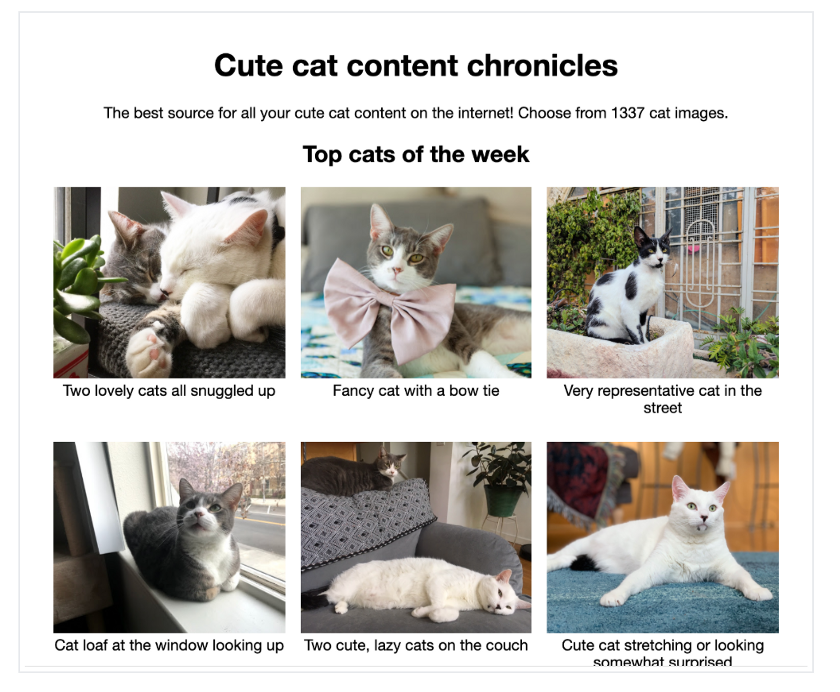

Come l’utente vede la pagina:

Come la pagina dotata di funzionalità JS, viene vista da Google:

Per consentire a Google di vedere il sito come lo vede l’utente, una soluzione può essere il Rendering dinamico.

Vuoi saperne di più? Leggi il nostro articolo sul complicato rapporto tra Javascript e SEO.

Un altro caso che non permette ai crawler di scansionare le pagine del tuo sito sono le violazioni delle linee guida per i webmaster. In questo caso sarà lo stesso Google ad avvisarti con un messaggio che troverai nel pannello della Search Console.

Indicizzazione: come si comporta Google

Abbiamo visto come si comporta il motore di ricerca nella sua fase iniziale di analisi del sito e quali sono le principali implementazioni a cui fare attenzione. Una volta superato questo step, Google invia le pagine scansionate al suo indice, tenendolo sempre aggiornato.

Per questo, dovresti prenderti cura del tuo sito scrivendo contenuti utili per gli utenti, che diano risalto ai tuoi servizi/prodotti evidenziandone i punti di forza rispetto ai competitor. Struttura i tuoi contenuti in maniera chiara, assicurati che tutte le pagine siano raggiungibili, ottimizza i tuoi testi per keyword pertinenti.

Posizionamento: quali sono i principali fattori di ranking?

Google si avvale di specifici algoritmi che contribuiscono a selezionare le pagine web del suo indice che rispondono meglio alle domande degli utenti.

Esistono diversi fattori basati sulla qualità, che influiscono sul posizionamento (o ranking), di cui devi prenderti cura se vuoi essere presente in serp con il tuo sito.

- Qualità dei contenuti: non smetteremo mai di dirlo, i contenuti sono super importanti. Ricordati di scrivere prima di tutto per gli utenti e di inserire parole chiave che ne esaltano il contesto: mi raccomando stai attento a non creare duplicati altrimenti Google potrebbe penalizzarti (dai uno sguardo alle linee guida Google su come gestire i contenuti duplicati). Così il tuo sito avrà più probabilità di essere pescato dall’indice e di posizionarsi tra i primi risultati.

- Qualità dei link: fai linkare il tuo sito da fonti esterne autorevoli. Questa attività, chiamata link building farà acquisire al tuo sito fiducia da parte di Google. Se vuoi saperne di più leggi il nostro articolo su come costruire una strategia vincente con la link building.

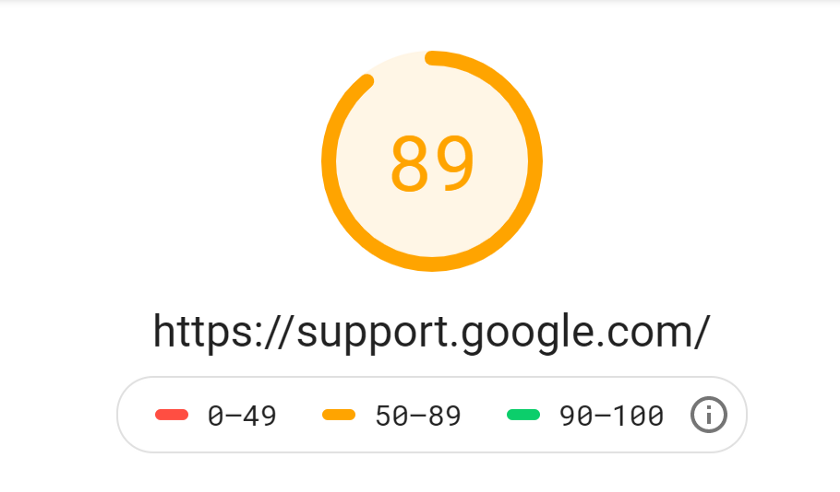

- Velocità del sito: migliora le prestazione del tuo sito da desktop e mobile. Esistono degli strumenti che ti permettono di misurare le performance in termini di velocità di caricamento del tuo sito web. Prova ad inserire l’url del tuo sito nel Tool PageSpeed Insigth di Google per ricevere suggerimenti su come migliorare la velocità di caricamento delle pagine del tuo sito da desktop e mobile.

Facciamo un test insieme e vediamo se il dominio support.google.com ottiene un buon punteggio di Performance:

Speed Test — Desktop

Speed Test — Mobile

Big G sembra non cavarsela tanto male in termini di performance! Tuttavia, per ogni sito esistono dei margini di miglioramento. Utilizza i suggerimenti del tool per ottimizzare gli elementi che potrebbero causare tempi di caricamento troppo lunghi.

Continua ad approfondire

Hai trovato interessante questa guida?

Possiamo fare tanto per aumentare la visibilità del tuo sito. Mettici alla prova, raccontaci di te e della tua realtà!